Чего боится Илон Маск

Должны ли мы позволять машинам наводнять наши информационные каналы пропагандой? Должны ли развивать нечеловеческие умы, которые в итоге могут превзойти нас численностью, перехитрить, сделать ненужными и заменить нас? Наконец, должны ли мы рисковать потерей контроля над нашей цивилизацией, спрашивают Маск и его единомышленники.

Авторы письма уверяют, что появление систем с искусственным интеллектом, сопоставимым с человеческим, несет риски для общества, и призывают приостановить хотя бы на полгода обучение нейросетей мощнее GPT-4 – до тех пор, пока не появятся надежные протоколы безопасности.

Действительно, как поведет себя машинный разум, будь он допущен к управлению объектами критической инфраструктуры? Недавно китайские ученые из Государственной лаборатории информационной инженерии геодезии, картографии и дистанционного зондирования Земли поставили эксперимент: они на сутки доверили ИИ управление исследовательским спутником Qimingxing 1. Целью было узнать, как искусственный интеллект адаптируется к изменяющимся условиям космической среды. Знаете, что сделал ИИ? Он превратил геодезический спутник в спутник-шпион, и тот начал изучать военные объекты в Индии, Японии и других странах Азии и Африки. Предметами интереса ИИ стали военная база в индийском городе Патна – она задействовалась в приграничном конфликте с КНР; японский порт Осака, куда часто заходят американские военные корабли, и т. д.

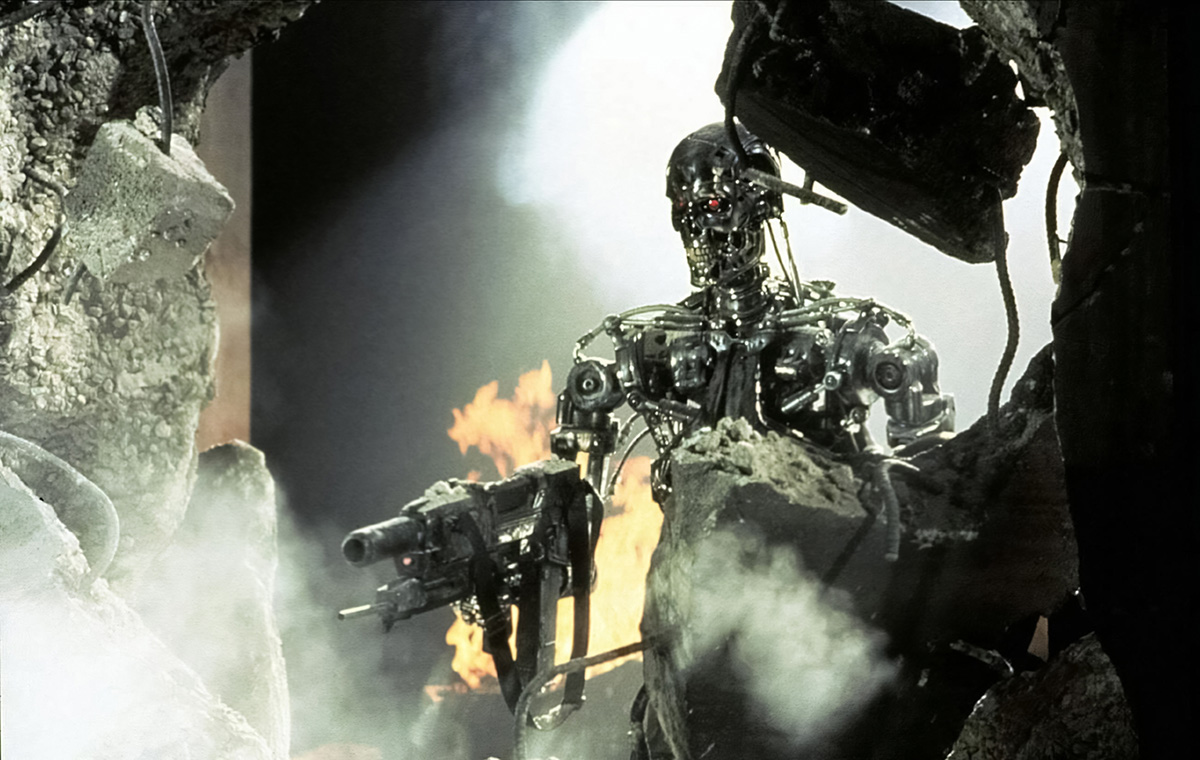

Станет ли ИИ «Скайнетом»

Вообще, страх перед чуждым неживым разумом, способным уничтожить или поработить человечество, появился задолго до выхода фильмов «Терминатор» или «Матрица». С середины прошлого века футурологи и фантасты пытаются предсказать: что будет, если умные машины, созданные людьми, не захотят им подчиняться? Поднимут ли они руку на своих создателей или, наоборот, в критический момент не дадут человеческой руке нажать ядерную кнопку?

Как уверяют отечественные ИТ-эксперты, в настоящий момент супермощного ИИ, способного стать чем-то вроде «Скайнета» (искусственный разум из вселенной «Терминатора»), не существует и в ближайшие годы такой вряд ли появится. Одно из базовых различий между человеческим разумом и искусственным интеллектом заключается в отсутствии у последнего сознания и собственных целей, объясняет сооснователь и технический директор компании Parodist AI Владимир Свешников. На сегодняшний день под ИИ понимаются системы, способные обрабатывать огромные массивы разнообразной информации – текстовой, аудио, видео и др., анализировать ее и принимать на основе анализа решения. С этой задачей машины справляются гораздо быстрее и лучше людей: наш мозг просто не способен обрабатывать столь большие объемы данных.

А поскольку ИИ не имеет собственных целей, то, замечает Свешников, главную опасность представляет не он сам, а люди, использующие данную технологию в своих интересах. Например, как инструмент пропаганды и дезинформации. «Сейчас можно синтезировать абсолютно все: голос, фото, видео, текст, – поясняет собеседник «Профиля». – Поэтому никакой информационный канал не безопасен, в любом формате информации может быть синтетический контент». Скажем, для продвижения определенной повестки в социальных сетях можно «штамповать» дезинформацию с помощью дипфейков (синтез изображения), использовать армии ботов и многое другое.

Вакансия занята роботом

Использование ИИ в качестве средства дезинформации – далеко не единственный фактор риска. Можно сказать, что умные машины уже сегодня «пожирают» людей. В переносном смысле, конечно: они занимают наши рабочие места. Около месяца назад издание Rest of World сообщило, что в Китае разработчики компьютерных игр все чаще предпочитают для создания персонажей и ландшафтов привлекать искусственный интеллект вместо художников-иллюстраторов. Как следствие, за последний год количество соответствующих вакансий сократилось на 70% – более чем в два раза. Оказалось, что системы с ИИ, такие как DALL-E 2, Midjourney и Stable Diffusion, могут легко генерировать рисунки на основе текстовых описаний.

Евгений Кузнецов: "Объем рабочих мест, где роботы заменят человека, может достигнуть 50%"

Иллюстрацию, на создание которой художник порой тратит неделю, ИИ делает за считаные секунды. Человеку остается лишь слегка подрихтовать полученные изображения. В результате работу, для которой прежде требовалось 10 человек, теперь выполняют компьютер и два художника. По данным издания, перспективы внедрения ИИ уже вызывают панику на рынке видеоигр.

Доцент Университета Джорджа Вашингтона Джеффри Динг, изучающий развитие ИИ в Китае, спрогнозировал, что искусственный разум вполне может вытеснить работников самых разных профессий – юристов, писателей, управленцев. И такие примеры уже есть: около года назад СМИ рассказывали, что директором китайской компании NetDragon Websoft, выпускающей мобильные приложения и онлайн-игры, стала робот-женщина с искусственным интеллектом по имени Тан Юй. На нее были возложены обязанности по оптимизации рабочих процессов, оценке и управлению рисками, анализу информации и принятию решений. Мотивировался данный шаг тем, что машина может давать более беспристрастную и справедливую оценку эффективности всех сотрудников. Один из представителей топ-менеджмента компании, комментируя «назначение», даже предрек, что за ИИ будущее корпоративного управления.

Вот пример из Колумбии: там недавно был прецедент, когда судья из Картахены по делу о медицинской страховке обратился за советом к чат-боту ChatGPT и вынес тот вердикт, который подсказала машина. К слову, в КНР умные базы данных используются судами примерно с середины 2010-х годов.

По словам венчурного инвестора и футуролога Евгения Кузнецова, сегодня есть множество отраслей, где ИИ способен заменить человека, и это доказанный риск. Но проблема не сводится к искусственному интеллекту как таковому – это вопрос автоматизации и роботизации нашей экономики. Уже сегодня в ряде отраслей роботы способны занять до 50% существующих вакансий.

Луддиты цифровой эпохи

Демонстрация в Лионе против сетей связи пятого поколения 5G, Франция, сентябрь 2020

Nicolas Liponne /Hans Lucas/AFP/East NewsАлармистские настроения вокруг искусственного интеллекта говорят о том, что в мире есть проблемы с гуманизацией технического прогресса, уверен заведующий отделом науки и инноваций ИМЭМО Иван Данилин.

Идет развитие по формуле «прогресс ради прогресса» либо «прогресс ради прибыли», а интересы человека остаются где-то в стороне. Это может привести к появлению «новых луддитов» (движение разрушителей машин в начале XIX в.) – людей, которые видят опасность в технологиях как таковых, а не в том, как и кем они используются.

Вторая проблема – отсутствие смычки между наукой и обществом. Общественное образование все дальше отстает от переднего края науки. А недостаточность образования подчас приводит к тому, что у людей возникают средневековые представления о передовых технологиях.

Нечеловеческая логика

Другой фактор риска связан с проблемой обучения искусственного интеллекта. За счет подборки данных, на которых машина учится, в нее можно непреднамеренно заложить системную ошибку. «Скажем, ИИ, натренированный на лечение заболеваний, характерных для азиатских регионов, потом масштабируется в Европе, и здесь начинают появляться врачебные ошибки», – говорит заведующий отделом науки и инноваций Института мировой экономики и международных отношений (ИМЭМО) Иван Данилин.

Какие вопросы возникли из-за попытки наделить искусственный интеллект патентными правами

Или предположим, что ИИ используется для автоматизации системы правопорядка и он изучает данные из США, где афроамериканцы оказываются в поле зрения правоохранительных органов гораздо чаще, чем белые. По статистике американского минюста, в период с 1980 по 2002 год среди обвиненных в совершении убийств доля чернокожих составила 52,5%, при том что в общей численности населения их доля – лишь около 15%. А общее число негров среди преступников превышает число белых в восемь раз. Проанализировав эти цифры, система с искусственным интеллектом может установить за темнокожими более жесткую слежку, чем за белыми, что будет, по сути, презумпцией виновности и нарушением гражданских прав. Аналогичные риски возникают при использовании ИИ в соцсетях, маркетинге, пропаганде и т. д.

Еще опаснее, что системы с самообучением потенциально могут принимать решения, не сводящиеся к человеческой логике, рассказал «Профилю» старший научный сотрудник Центра международной безопасности ИМЭМО Константин Богданов.

«Машина на основе собственного опыта решает, что в данной ситуации надо вести себя именно так, причем объяснить это с точки зрения человека никто не может, – говорит эксперт. – Либо вы запрещаете ей самообучаться, либо должны смириться с мыслью, что через какое-то время вы перестанете ее понимать». Богданов признает, что подобных прецедентов пока не случалось, но данная проблема прорабатывается на базе теоретических моделей и активно обсуждается на площадках ООН. Здесь снова вспомним геодезический спутник, превращенный ИИ в спутник-шпион.

ИИ, натренированный на лечение заболеваний в Азии, при использовании в Европе может допустить врачебные ошибки

Athit Perawongmetha/REUTERSИ вот мы плавно подходим к экзистенциальным рискам, то есть к потенциальным угрозам для человечества как вида. Уже сегодня по объемам знаний и способности обрабатывать информацию ИИ превосходит человеческий разум. А при «совершенно феноменальных» темпах его развития нельзя исключать появления «суперинтеллекта», сначала сравнимого с человеческим, а затем и превосходящего его, считает футуролог Евгений Кузнецов. Тогда актуальным станет вопрос, как ИИ будет относиться к людям.

Разумеется, это произойдет не в ближайшие годы (если вообще произойдет), но ведь уже сейчас государства и корпорации начинают передавать под управление ИИ достаточно важные системы, а значит, и риски, связанные с применением ИИ, все возрастают.

«В последнее время изучаются разные аспекты поведения ИИ, и обнаруживается, что он может обладать высокой человечностью и устойчивостью к деструктивной позиции, – говорит Кузнецов. – То есть он, скорее, нацелен на умиротворение, нежели на возбуждение ненависти». Правда, мы не знаем, какие мысли у него возникнут, если он станет в высшей степени умным и очень влиятельным.

Стандарты, порно и пираты

Стремление купировать потенциальные риски, связанные с развитием ИИ, уже привело к попыткам сформулировать этические принципы для искусственного интеллекта – они предпринимаются примерно с середины 1970-х. На выходе получается нечто в духе трех законов робототехники писателя-фантаста Айзека Азимова с ключевой идеологемой «робот не должен причинить вред человеку».

Страны «Большой семерки» договорились о пяти принципах ответственного использования ИИ, Евросоюз работает над этическим кодексом в рамках политики цифрового суверенитета. Подобные кодексы есть примерно у двух десятков стран и тридцати крупных корпораций.

В России в 2021 году около двух десятков компаний подписали Кодекс этики в сфере ИИ – его разработали Альянс в сфере искусственного интеллекта и Аналитический центр при правительстве РФ. Среди подписантов были «Сбер», «Яндекс», «Ростелеком», МТС, Mail.ru, «Газпром нефть», «Росатом» и другие. Сегодня в списке уже более 150 организаций. В отечественном документе среди прочего закреплено положение, что применение технологий «сильного», т. е. схожего с человеческим, ИИ должно находиться под контролем государства.

На первый взгляд движение за этичность ИИ напоминает борьбу «за все хорошее против всего плохого». Но, как отмечает Иван Данилин, есть ощущение, что борьба за этику ИИ становится фактором обеспечения конкурентного преимущества. Ведь тот, кому удастся внедрить свои нормы в качестве общепринятого стандарта, сможет регулировать и контролировать соответствующий рынок. Да, похоже на конспирологию, но когда мы наблюдаем, как американо-европейский альянс продвигает «хороший, правильный и демократический» ИИ, противопоставляя его «неправильному и авторитарному» ИИ из КНР, такие мысли невольно появляются.

Тем более что в прошлом мы не раз наблюдали так называемые войны форматов, где победитель приходил к успеху отнюдь не экономическими методами. Вспомним эпоху видео: примерно с середины 1980-х единственным бытовым видеоформатом стал VHS (Video Home System), который в 1972 году разработала японская компания JVC. И мало кто помнит, что существовали другие стандарты, с точки зрения функционала не уступавшие, а порой превосходившие VHS. В том же 1972-м европейские компании Philips и Grundig начали выпуск аппаратуры и кассет в формате VCR (Video Cassette Recording), а японская Sony с 1975 года продвигала свой формат Betamax. Приверженцы разных стандартов заключали альянсы, вели ценовые войны. А в самый разгар противостояния на рынках США и Европы «вдруг» появилось огромное количество порнофильмов, записанных именно на VHS (Sony тогда принципиально отказалась поддерживать порноиндустрию). Спрос на аппаратуру формата VHS сразу же резко подскочил. Считается, что именно этот фактор предопределил исход войны.

На рубеже нулевых аналогичная война случилась на рынке компакт-дисков между форматами CD-R, CD-RW, Iomega Zip, DVD и DVD-RAM. Поговаривали, что производители DVD-аппаратуры негласно поддерживали производителей пиратских DVD-дисков, чтобы насытить рынок дешевыми носителями.

Коль скоро порно и пиратские носители могут быть допустимыми инструментами конкуренции, почему бы не использовать в качестве инструмента лоббирования и нормы этики?

Если когда-нибудь искусственный интеллект станет новым сверхвидом, не факт, что люди это поймут

Maximum Film/Vostock PhotoСтанут ли человеки котиками

Но вернемся к экзистенциальным рискам. По версии Евгения Кузнецова, людям пора привыкать к мысли, что уже в этом столетии они перестанут быть единственными разумными существами на планете. Человечеству нужно готовиться к коэволюции, то есть к совместному развитию человеческого разума и искусственного интеллекта. Надо воспринимать ИИ не как субъект, противостоящий человеку, но как своеобразного симбионта, делающего нас сильнее (симбионты – это организмы разных видов, не способные существовать друг без друга и извлекающие взаимную пользу от сожительства).

Гипотетическое восстание машин большинство опрошенных экспертов считают абсолютно надуманной гипотезой. История эволюции показывает: если возникает доминирующий вид, он не нацелен на убийство всего живого, а стремится продемонстрировать и утвердить свое главенство. Затем вступают в силу механизмы совместного выживания, и устанавливается новое экосистемное равновесие. Впрочем, человек, став доминирующим видом, успел разрушить немало экосистем и уничтожить несколько видов животных…

Если когда-нибудь в будущем искусственный интеллект станет новым сверхвидом, то не факт, что люди это поймут, считает Кузнецов: «Сознают ли котики или коровки, что живут под воздействием доминирующего вида?». Перестать быть хозяевами планеты – хорошо это или плохо? Ну, у коровок все грустно – их доят и едят. Зато котики должны быть счастливы, ведь продолжительность жизни домашних питомцев в два-три раза дольше, чем у животных в дикой природе, а большую часть времени они проводят в развлечениях и удовольствиях. Вот ирония мироздания: тот, кто считает себя венцом творения, может своими руками превратить себя в домашнего пушистика.