В чем проблема

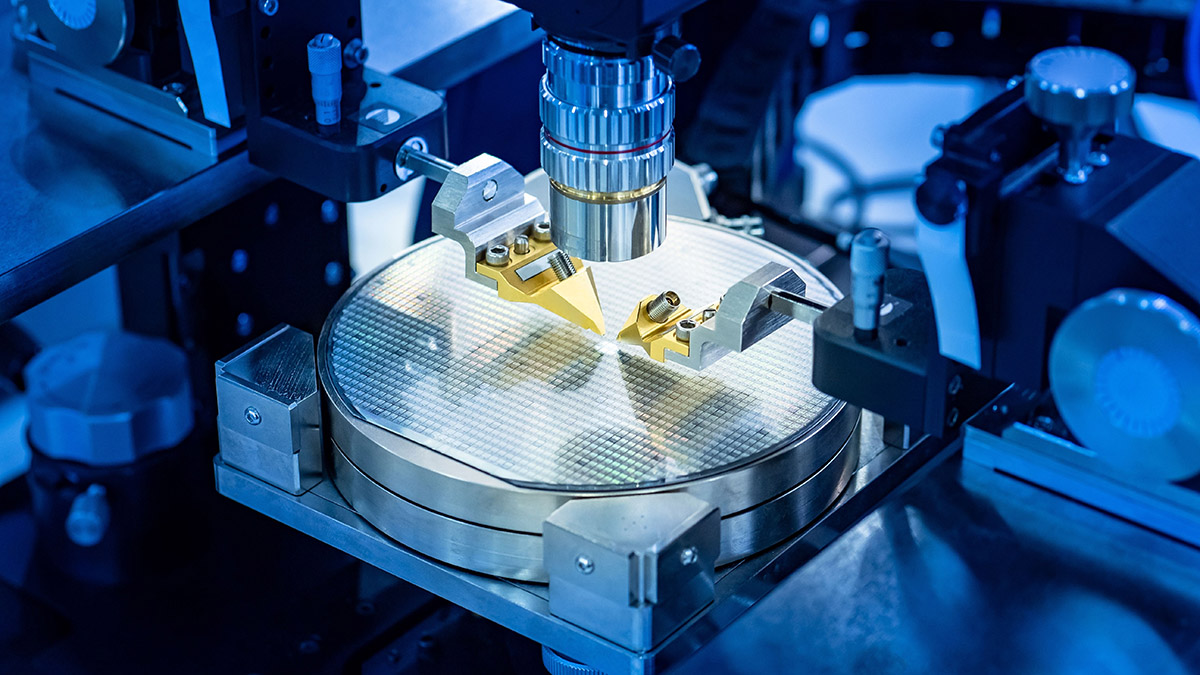

Один из ключевых показателей эффективности современного процессора – топология. Исторически она показывала плотность расположения и размер канала в транзисторе – кремниевом кристалле, который пропускает либо не пропускает ток (и таким образом определяет 0 или 1 в компьютерном коде). Эта плотность измеряется в нанометрах, и самое современное поколение процессоров производится по топологии 3 нм.

Правда, с определенного момента топология стала больше маркетинговым, нежели физическим показателем. Все дело в архитектуре. Раньше транзистор был плоским, и топология действительно показывала физическую величину его канала. Но к сегодняшнему дню корпорации разработали несколько видов трехмерных транзисторов с несколькими каналами, взаимодействующими друг с другом по сложным схемам, и показатель нанометров перестал совпадать с реальными величинами, став, скорее, условной метрикой.

Это привело к путанице: два поколения 3-нанометровых процессоров могут иметь разное количество транзисторов на одной и той же площади. Так, например, произошло с чипами Apple M3 и M4 или A17 и A18, представленными в 2023 и 2024 годах соответственно. А несколько лет назад выяснилось, что плотность транзисторов в 7-нанометровых чипах Intel выше, чем в 5-нанометровых у других компаний.

Сколько интеллекта в "яблоке": сможет ли Apple снова изменить ИТ-рынок?

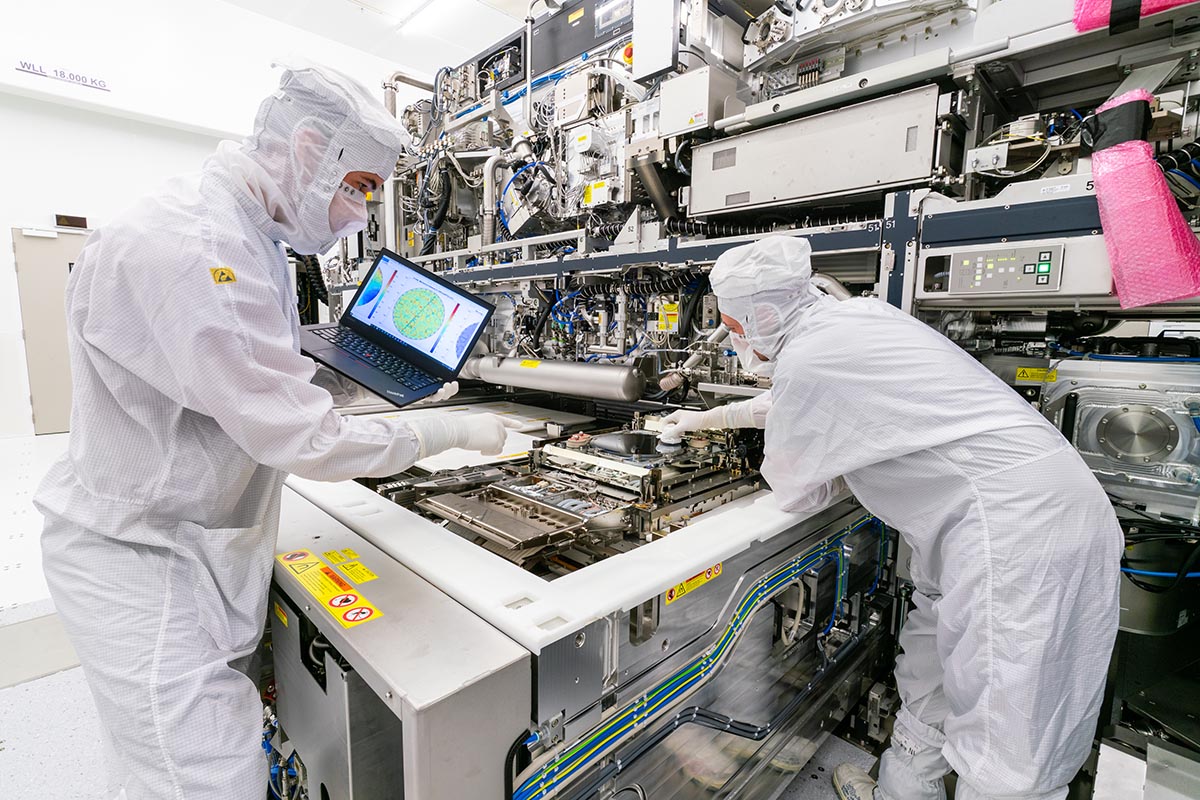

Сегодня начато производство 2-нанометровых чипов, в разработке находятся чипы 1,6, 1,4 и даже 1 нм. И здесь несколько новых проблем. Во-первых, способ производства. Если коротко, создавать столь миниатюрные транзисторы возможно только с помощью дорогого оборудования для специальной ультрафиолетовой фотолитографии. В мире есть только одна компания, которая производит такие машины – огромные устройства стоимостью десятки и сотни миллионов долларов, – нидерландская ASML.

Компания разработала оборудование, способное работать с транзисторами в диапазоне 2–3 нм – всего их пока произведено 10 штук рыночной стоимостью $300 млн каждая. А к 2027 году ASML обещает представить литографы, способные работать по топологии до 1 нм.

Да, эти нанометры – все еще элемент маркетинга: по факту такие транзисторы немного больше. Однако их плотность все равно уменьшается год от года, и неизменным остается вопрос: что будет, когда мы достигнем предела уменьшения кремниевых чипов? А ведь этот день все ближе: диаметр одного атома кремния составляет 0,264 нм, и с учетом межатомного расстояния нынешние топологии очень близки к физическому пределу.

Как «работают» нанометры

Топология чипа определяет, сколько транзисторов может находиться на кремниевой пластине. Чем больше транзисторов – тем выше производительность. В то же время чем меньше транзистор, тем меньше энергии он требует. Поэтому 3-нанометровый чип позволяет решать более сложные задачи, чем аналогичный 5-нанометровый, при этом расход энергии у него не растет или даже немного снижается.

Производителям приходится решать несколько инженерных проблем, главная из которых – перегрев. Чем плотнее транзисторы, тем сильнее греется чип и тем активнее нужно его охлаждать. До определенного момента нагрев некритичен, однако замедляет работу чипа, и в худшем случае чип попросту перестанет работать.

Вторая проблема – квантовые эффекты. На уровне нанометров начинает действовать квантовая физика, что приводит к ошибкам. Среди них – туннелирование, то есть преодоление электронами барьеров и таким образом «утечка» энергии и ошибки в данных, а также вредное влияние фотонов. Такие проблемы решаются с помощью усложнения архитектуры транзисторов.

Углерод вместо кремния

Главный претендент на то, чтобы заменить кремний в вычислениях, – графен, двумерный слой углерода толщиной в один атом с шестиугольной структурой. Он наделал немало шума в нулевых и 2010-х, но затем почти пропал из инфополя: ученым никак не удавалось реализовать огромный потенциал вещества, о котором они так много говорили.

В 2024-м ситуация как будто начала меняться: в начале года ученые Технологического института Джорджии заявили, что после десяти лет исследований сумели добиться стабильной работы графена в качестве полупроводника. Напомним: полупроводник – это вещество, которое в зависимости от условий может либо проводить электричество, либо не проводить (как, например, кремний), что и позволяет обеспечивать транзистору либо 0, либо 1.

Подробные технические характеристики пока не приводятся, но зато команда из Джорджии утверждает, что по сравнению с традиционными кремниевыми чипами вычисления могут вестись до 10 раз быстрее. При этом энергопотребление будет ниже, равно как и нагрев. Что автоматически дает более долгий срок жизни потенциальным устройствам: ноутбуки и смартфоны по неделе смогут работать без подзарядки. И при этом они будут мощнее.

Кроме того, атом углерода меньше атома кремния, а значит, и графеновых транзисторов на той же площади удастся разместить больше – опять же прирост к вычислительной мощности. Ну и вишенка на торте: ученые говорят о совместимости с традиционными кремниевыми вычислениями. Это значит, что принципиально менять архитектуру устройств при замене кремниевых процессоров на графеновые не придется, хотя доработки понадобятся, конечно, серьезные.

Ключевых проблем тут две. Первая – утечка электронов: из-за свойств графена электроны могут покидать поверхность полупроводника, что приводит к снижению энергоэффективности и повышению теплоотдачи. Команда университета Джорджии утверждает, что проблему ей решить удалось, но подробности не приводятся.

Вторая – промышленное производство. Одно дело – создать тестовый чип в наполовину кустарных условиях, и совсем другое – наладить производство миллионов таких процессоров для современных устройств. Понятно, что это будет происходить постепенно, но качественный рывок все же потребуется. Впрочем, на фоне дорогостоящей и экстремально сложной фотолитографии производство графеновых чипов в конечном итоге может оказаться даже выгоднее – если, конечно, ученые подобрали правильный ключик к этому материалу.

Компания ASML разработала оборудование, способное работать с транзисторами в диапазоне 2–3 нм

ASMLНе все дело в нанометрах

Возвращаясь к теме топологии, стоит отметить, что передовой – не значит массовый. Да, в повседневных устройствах – смартфонах и ноутбуках – мы хотим видеть самые мощные чипы с минимальной топологией. Но есть рынки прочей электроники, где мощные вычисления не являются определяющими.

Например, чипы в цифровых платформах люксовых автомобилей отстают на 1–2 поколения – сейчас это 3–5 нм. В бытовой электронике чипы и контроллеры и вовсе делаются на базе чипов с топологией в десятки, если не сотни нанометров.

В России показателен пример разработчика чипов «Эльбрус» МЦСТ. Как и большинство чипов в мире, раньше они изготавливались на тайваньской TSMC, но сейчас производство постепенно перебирается в Россию. Так вот, к 2028 году компания собирается запустить серийное производство 65-нанометровых чипов, а самый передовой процессор в линейке имеет топологию 28 нм. И спрос на них будет в любом случае: хотя бы под серверы, которые критично импортозамещать.

Да будет свет

Еще одна альтернатива – фотонные процессоры. В отличие от графеновых полупроводников, фотоника, напротив, не является чем-то принципиально новым. Самая быстрая и стабильная интернет-связь обеспечивается как раз таким образом: данные передаются с помощью фотонов по оптоволоконным кабелям. Почему бы не использовать этот принцип для того, чтобы в процессорах тоже заменить электроны частицами света – фотонами?

Спроси по-человечески: как нейросети изменят систему поиска информации в интернете

Несмотря на то, что электроны и фотоны движутся примерно с одинаковой скоростью (в идеальных условиях – со скоростью света), у последних есть заметное преимущество: они не взаимодействуют друг с другом. Это значит, что по одному каналу можно передавать не один поток данных, а сразу несколько, что на порядки повысит скорость вычислений. Плюс фотоны требуют меньше энергии для запуска и обеспечивают меньшее тепловыделение, а значит, фотонные процессоры также будут энергоэффективнее.

Как всегда, в такой бочке меда есть изрядная ложка дегтя, и в случае с фотонами это функциональность. До сих пор ученым и инженерам не удалось придумать универсальную архитектуру фотонного чипа, которая была бы применима для разных типов задач. Один тип процессора – один тип задач: именно такое ограничение у фотонных вычислений.

Решить эту проблему пытаются ученые всего мира, в том числе и России. В этом году Самарский университет им. С.П. Королева показал прототип фотонного процессора, настроенного на работу с большими данными. К 2030 году исследователи рассчитывают создать на основе технологии суперкомпьютер – опять же именно под эту конкретную задачу.

Полусветовой переход

Частичное решение проблемы негибкой функциональности – оптоэлектронные процессоры. Они объединяют преимущества двух систем: для вычислений используются кремниевые транзисторы на базе электронов, а передача данных происходит за счет света. И хотя при преобразовании данных из фотонов в электроны и обратно теряется до 30% энергии, такие чипы сегодня кажутся весьма перспективным направлением.

Разработками таких чипов – с прицелом на работу с ИИ – занимаются несколько заметных мировых стартапов: Salience Labs (объединенный проект Оксфорда и Университета Мюнстер) и LightMatter (который переманил к себе одного из топ-менеджеров Nvidia). У них уже есть готовые продукты, но на рынке они пока не снискали особой популярности, поскольку еще не доказали свою функциональность по сравнению с обычными GPU.

Но скоро это может измениться. В июле этого года корпорация Intel представила оптоэлектронную платформу OCI. Инженеры решили использовать тот факт, что фотоны способны преодолевать большее расстояние без потерь, за счет чего создают более сложные и масштабные вычислительные архитектуры. Первый чип на базе новой платформы способен поддерживать параллельно 64 канала со скоростью 32 Гбит/сек – это свыше 2 Тбит/сек. Для сравнения: представленные в этом году ИИ-ускорители Nvidia B200 более чем вдвое медленнее: до 900 Гбит/сек.

Кванты как помощники

Про квантовые вычисления тоже уместно говорить в контексте передовых разработок, но есть нюанс. Такие компьютеры никогда не заменят традиционные битовые вычисления, а станут, скорее, дополнением.

Самые передовые квантовые разработки (например, компаний IBM и Google) направлены на создание устойчивых объединений из нескольких групп кубитов (квантовых битов). Они должны быть не подвержены ошибкам на уровне по крайней мере 99%. А помогают им в этом алгоритмы искусственного интеллекта, которые вычисляются на традиционных графических процессорах.

Квантовые вычисления, в свою очередь, станут платформой для обучения ИИ-алгоритмов. Поскольку кванты идеально подходят под задачи моделирования, они смогут создавать искусственные наборы данных (датасеты), которые позволят существенно развивать искусственный интеллект. Иными словами, самой эффективной для таких задач в будущем станет именно связка квантовых и классических вычислений, но никак не квантовые компьютеры по отдельности.

Биомозг для ИИ

Самой футуристичной и в то же время противоречивой альтернативой кремнию сегодня можно назвать биологические, или клеточные компьютеры. Это направление пока находится на сравнительно ранней стадии исследований, и до коммерческих применений еще очень далеко, но некоторые успехи у профильных лабораторий уже есть.

Как следует из термина, биологические процессоры (биопроцессоры) – органические вещества, клетки, которые производят вычисления. На данный момент нет консолидированного и тем более стандартизированного подхода к этому направлению. Но есть многообещающие разработки, в основе которых лежит генетическое редактирование.

Привычное «железо» в данном случае заменяют живые клетки – само собой, не обладающие каким-либо разумом. В качестве «памяти» выступают нити ДНК, в которые закодирована четверичная информация (гены A, C, G, T – против классической двоичной, с 0 и 1 в основе). РНК-компоненты отвечают за считывание и записывание информации в ДНК – схожим образом это работает в действительно живых организмах. Ну а управлять таким «устройством» можно с помощью генного редактирования либо электрических импульсов.

Звучит жутковато и фантастично, но за реальным примером далеко ходить не надо: в мае нынешнего года швейцарский стартап FinalSpark запустил платформу, позволяющую исследовательским командам (кому-то бесплатно, а кому-то за деньги) удаленно подключиться к такой биоплатформе для проведения собственных исследований.

Платформа состоит из органоидов – мозговых веществ, выращенных на основе стволовых клеток человека, соединенных в сеть и помещенных в питательную среду. Потребовалось ли в данном случае генное редактирование, неизвестно: за управление и преобразование сигналов из цифровых в биологические и обратно отвечают специальные электроды. Разработчики утверждают, что подобная платформа в разы энергоэффективнее и мощнее, нежели кремниевые аналоги.

Кроме того, такие биокомпьютеры способны обучаться (как человеческий мозг) и восстанавливаться (как органические вещества). Здесь же кроется и весьма коварный подводный камень: далеко не всегда понятно, как именно будут проходить вычисления, какой логике они будут следовать. Иными словами, доказать жизнеспособность такой концепции пока только предстоит. Равно как и решить ряд этических вопросов: исследования в этой области очень близки к серой зоне, где не до конца понятно, какими могут быть последствия.

Исследования в этой области ведутся уже десятилетия, но в последние годы ученые заговорили о перспективности технологии в контексте искусственного интеллекта. Собственно, как и инженеры всех остальных перспективных вычислительных платформ, – практически все говорят о связке вычислений с ИИ. И неспроста: именно эта технология серьезно повысила требования к количеству и качеству вычислительных мощностей.

Они, отвечая спросу, активно растут, но пока лишь количественно. И при этом стремительно приближаются к «потолку» нынешнего поколения кремниевых технологий. А значит, качественный скачок – каким бы он ни был – действительно должен случиться в обозримом будущем. Вероятно, уже в этом десятилетии.